インターネット上のデータを収集する作業は、時間と労力がかかることが多いですが、Excelを使ってスクレイピングを自動化することで、効率的にデータ収集を行えるようになります。この記事では、Excelの機能を活用してWebデータのスクレイピングを行う方法を解説し、誰でも簡単にデータ収集を自動化できるようになるためのノウハウを紹介します。業務や研究、個人の趣味など、さまざまな目的でのデータ収集に役立つテクニックを学んでいただければと思います。

エクセルでWebデータを自動更新するにはどうしたらいいですか?

エクセルでWebデータを自動更新するには、以下の手順で設定することができます。まず、Webデータをエクセルにインポートします。次に、データの更新スケジュールを設定します。これにより、指定した時間に自動的にWebデータが更新されます。詳細な手順は以下の通りです。

Webデータのインポート

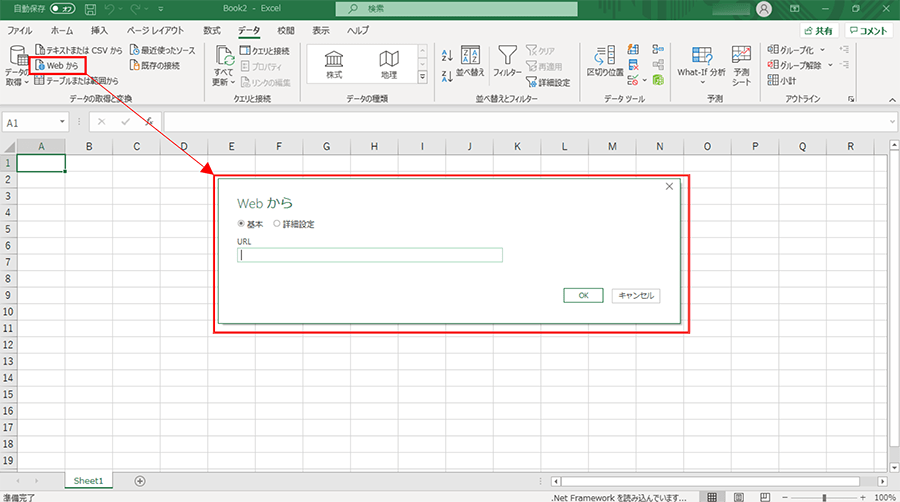

エクセルにWebデータをインポートする手順は以下の通りです。

- エクセルを開き、新しいブックを作成します。

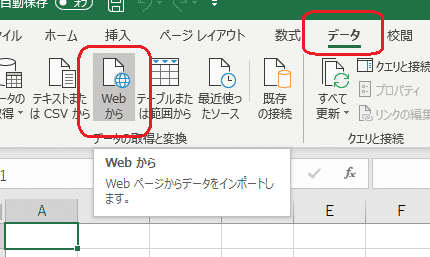

- データタブをクリックし、Webから取得 を選択します。

- データを取得したいWebページのURLを入力し、接続 ボタンをクリックします。

データの更新スケジュールの設定

データの更新スケジュールを設定する手順は以下の通りです。

- インポートしたデータを選択し、右クリックします。

- メニューから 接続の編集 を選択します。

- 「接続のプロパティ」ダイアログボックスで、更新設定 に移動し、必要な更新間隔を選択します。

更新エラーの対処方法

更新エラーが発生した場合の対処方法は以下の通りです。

- エラー内容を確認し、必要な修正を行います。

- URLが正しいか、Webページが存在するか確認します。

- ネットワーク接続が正常に機能しているか確認します。

スクレイピング対策にはどのような方法がありますか?

スクレイピング対策には、さまざまな方法があります。以下に代表的な対策を紹介します。

1. ロボット排除プロトコル(robots.txt)の活用

robots.txtファイルをウェブサイトのルートディレクトリに配置することで、特定のページやディレクトリをーリングから除外できます。この方法は、検索エンジンのーラーがアクセスするのを制限できますが、悪意のあるスクレーパーは無視する可能性があるため、補完的な対策が必要です。

- 特定のページやディレクトリを指定してールを禁止する。

- 検索エンジンのーラーにだけ制限を適用する。

- 書き換えや更新を頻繁に行い、スクレーパーの対策を難しくする。

2. キャプTCHAの導入

キャプTCHAは、人間とロボットを区別するための仕組みです。ユーザーに文字や画像の認識を要求することで、自動化されたスクレーパーのアクセスを防ぐことができます。ただし、ユーザーエクスペリエンスに影響を与える可能性があるため、適切な実装が重要です。

- ログインや検索フォームにキャプTCHAを設置する。

- 高頻度のリクエストを検知してキャプTCHAを表示する。

- achable CAPTCHAや画像認識タイプのキャプTCHAを使用する。

3. IPアドレスの制限とブロック

IPアドレスの制限やブロックは、特定のIPアドレスからのアクセスを制限する方法です。頻繁にアクセスするIPアドレスをモニタリングし、必要に応じてブロックすることで、スクレイピングの回数を減らすことができます。

- アクセスログを分析して異常なアクセスを検知する。

- IPアドレスのリストを定期的に更新し、ブロックする。

- プロキシサーバーの使用を検知し、対策する。

Excelを使ってWebデータ収集を自動化する方法

Excelを使ってWebデータ収集を自動化することは、ビジネスや研究において非常に便利なスキルです。Excelの機能を活用して、Webページからデータを抽出する方法を解説します。

Excelでスクレイピングが可能なアドインをインストールする

ExcelでWebデータ収集を自動化するためには、まず「Power Query」アドインをインストールする必要があります。「Power Query」は、Excel 2016以降のバージョンでは標準で搭載されていますが、Excel 2010や2013を使っている場合は、Microsoftの公式サイトからアドインをダウンロードしてインストールしてください。

Webデータの取得先を指定する

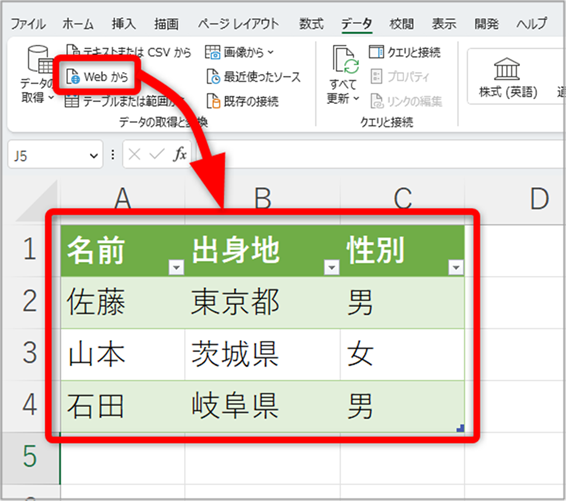

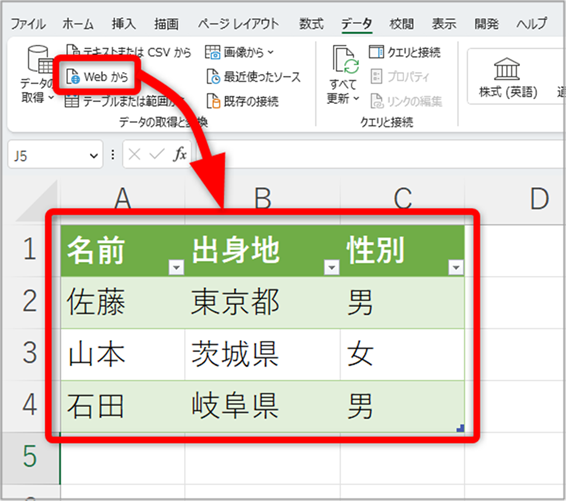

「Power Query」をインストールしたら、次はWebデータの取得先を指定します。取得したいWebページのURLを入力し、データを取得するためのクエリを作成します。

取得したいデータを選択する

Webページから取得したデータは、テーブル形式で表示されます。必要なデータだけを選択して、Excelのシートに取り込みます。この際、データの整形や加工も行えます。

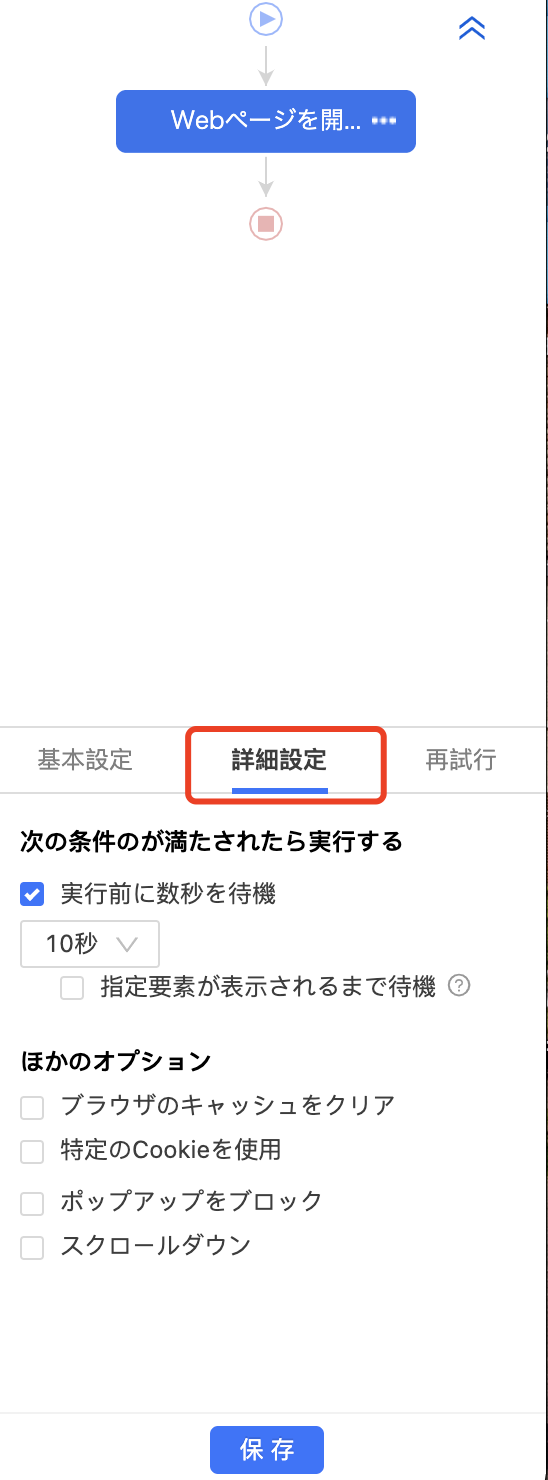

データの取得を自動化する

データの取得先や取得するデータを指定したら、次はその取得処理を自動化します。Power Queryの機能を使って、定期的にデータを取得するスケジュールを設定することができます。

取得したデータを分析する

Excelに取り込んだデータは、Excelの各種機能を使って分析できます。グラフを作成したり、データを整形したり、計算処理を行ったりすることで、Web上のデータを活用したビジネスや研究に役立てることができます。

| 手順 | 内容 |

|---|---|

| 1 | Power Queryアドインのインストール |

| 2 | Webデータの取得先の指定 |

| 3 | 取得したいデータの選択 |

| 4 | データ取得の自動化 |

| 5 | 取得したデータの分析 |

スクレイピングはなぜ禁止されているのですか?

データの保護とプライバシーの侵害

スクレイピングは、ウェブサイトからデータを自動的に収集する行為ですが、これが禁止されている主な理由のひとつは、データの保護とプライバシーの侵害です。多くのウェブサイトは、ユーザーの個人情報や企業の機密情報を含むデータを保持しており、これらのデータが無許可で収集されれば、深刻なプライバシー侵害につながります。

- 個人情報の漏洩: スクレイピングにより、ユーザーの名前、住所、メールアドレスなどの個人情報が漏洩することがあります。

- 企業情報の漏洩: 企業の機密情報がスクレイピングによって漏洩した場合、企業の競争力や信頼性に重大なダメージを与えることがあります。

- データの悪用: 収集されたデータが悪意のある第三者によって悪用されることがあります。例えば、フィッシング詐欺やアイデンティティ盗用などが挙げられます。

gq

サーバーの負担

スクレイピングは、ウェブサイトのサーバーに過度の負担を与えることがあります。大規模なスクレイピング活動は、ウェブサイトのパフォーマンスを低下させ、場合によってはサーバーのダウンにつながります。

- アクセスの集中: スクレイピングは短時間に大量のリクエストを送信するため、サーバーに過度の負担をかけます。

- 帯域幅の消費: スクレイピングによって帯域幅が過剰に消費され、他のユーザーのアクセスが遅くなることがあります。

- サービスの停止: 最悪の場合、スクレイピングによってサーバーがダウンし、ウェブサイトが一時的に利用できない状態になることがあります。

著作権侵害

スクレイピングは、著作権法に違反する可能性があるという点でも問題視されています。ウェブサイトに掲載されている文章、画像、動画などのコンテンツは、著作権で保護されていることが一般的です。これらのコンテンツを無許可で収集・利用することは、著作権侵害にあたる可能性があります。

- コンテンツの無断転用: スクレイピングによって収集されたコンテンツが、無許可で他のウェブサイトに転用されることがあります。

- 二次的著作物の作成: 収集されたデータを元に、二次的著作物が作成されることがあります。これも著作権侵害にあたる可能性があります。

- 収益の損失: 著作権者が収益を上げる機会を奪われることがあります。例えば、広告収益や有料コンテンツの販売収益が減少することがあります。

ExcelのWebデータを自動更新するにはどうしたらいいですか?

ExcelのWebデータを自動更新するには、以下の手順を実行します。

手順1: Web クエリを使用する

ExcelでWebデータを自動更新する最も一般的な方法は、Webクエリを使用することです。Webクエリは、Webページからデータを取得し、Excelに取り込むことができます。以下の手順でWebクエリを設定します。

- Excelで、「データ」タブを開き、「新しいクエリ」を選択します。

- 「他のソースから」を選択し、「Web」をクリックします。

- データを取得したいWebページのURLを入力し、「OK」をクリックします。

手順2: データのリフレッシュを設定する

Webクエリを設定した後、データの自動更新を設定する必要があります。以下の手順でデータのリフレッシュを設定します。

- データを取り込んだセルを選択し、「データ」タブを開きます。

- 「リフレッシュ」をクリックし、「リフレッシュの設定」を選択します。

- リフレッシュの間隔を設定し、必要に応じて他のオプションを選択します。

手順3: VBAを使用して自動更新をカスタマイズする

VBA(Visual Basic for Applications)を使用して、データの自動更新をさらにカスタマイズできます。以下の手順でVBAを使用して自動更新をカスタマイズします。

- Excelで、「開発」タブを開き、「Visual Basic」をクリックします。

- 「挿入」をクリックし、「モジュール」を選択します。

- VBAコードを入力して、データの更新をカスタマイズします。たとえば、一定の時間間隔でデータを更新するコードを追加できます。

WebサイトからデータをExcelに取り込む方法は?

WebサイトからデータをExcelに取り込む方法は以下の通りです。

方法1: Webクエリを使用する

Webクエリを使用すると、Excelから直接Webサイトのデータを取り込むことができます。この方法は、新しいデータとともにWebページが更新されるたびに、データを自動的に最新の状態に保つことができます。

- Excelを開き、データタブを選択します。

- 新しいクエリをクリックし、オプションからを選択します。

- Webをクリックし、データを取り込みたいWebページのURLを入力します。

方法2: Webページからコピー&ペーストする

シンプルに、Webページ上のデータをコピーしてExcelにペーストする方法もあります。この方法は、一度だけデータを取り込む場合に適しています。

- データを取り込みたいWebページを開き、データを選択してコピーします。

- Excelを開き、データをペーストします。

- 必要に応じてデータを整形します。

方法3: プログラミングを使用する

PythonやVBAなどのプログラミング言語を使用して、Webサイトからデータを抽出してExcelに取り込むこともできます。この方法は、複数のページから大量のデータを定期的に取り込む必要がある場合に適しています。

- Pythonなどのプログラミング言語とBeautifulSoupなどのライブラリを使用して、Webサイトからデータを抽出します。

- 抽出したデータをExcelに書き込みます。

- 必要に応じてプログラムを自動化し、定期的にデータを取り込みます。

ウェブスクレイピングは違法ですか?

ウェブスクレイピングは、その使用方法次第で合法的な手段にも違法的な手段にもなり得る技術です。ウェブスクレイピングが違法とされる場合には、以下の要素が関与していることが多いです。

著作権侵害

ウェブスクレイピングによってウェブサイトからデータを収集する際、そのデータが著作権で保護されているコンテンツである場合、無断で使用することは著作権侵害にあたることがあります。

- データの使用目的が営利目的である場合

- データの所有者から明示的な許可を得ていない場合

- データの使用がフェアユースの範囲を超えている場合

ウェブサイトの利用規約違反

多くのウェブサイトには、ウェブスクレイピングに関する特定の利用規約が定められています。これらの規約に違反する形でウェブスクレイピングを行うことは、ウェブサイトの利用規約違反とみなされることがあります。

- 規約で明示的にスクレイピングが禁止されている場合

- スクレイピングによってウェブサイトのサーバーに過度の負担をかける場合

- スクレイピングによってウェブサイトのセキュリティを脅かす行為を行う場合

個人情報の保護に関する法律違反

ウェブスクレイピングによって個人情報を収集する際、その行使が個人情報保護法に違反する場合は、個人情報の保護に関する法律違反にあたることがあります。

- 個人情報を適切な許可なく収集する場合

- 収集した個人情報を本人の同意なく第三者に提供する場合

- 収集した個人情報を安全に管理せず、漏洩させる場合

詳細情報

Webデータ収集を自動化する方法は何ですか?

Webデータ収集を自動化する最も一般的な方法は、スクレイピングです。スクレイピングとは、Webページからデータを自動的に抽出する技術です。Excelを使ってスクレイピングに挑戦することで、繰り返しの作業を減らし、効率的にデータ収集を行うことが可能です。

Excelでスクレイピングに挑戦する際に必要なものは何ですか?

Excelでスクレイピングに挑戦するには、以下のものが必要です。

- Excel: スクレイピングを行うための基本的なツールです。

- VBA: Excelでマを記述するためのプログラミング言語です。VBAを使用して、Webページからデータを抽出する処理を自動化します。

- Webクエリ: ExcelにWebページからデータを取り込む機能です。Webクエリを使用して、スクレイピング対象のWebページのデータをExcelに読み込みます。

Excelを使ってスクレイピングすることの利点は何ですか?

Excelを使ってスクレイピングすることの主な利点は以下の通りです。

- 効率的なデータ収集: 手動でデータを収集するよりも、自動化することで作業時間を大幅に削減できます。

- シンプルな操作: ExcelとVBAを使ってスクレイピングを実行するため、特別なプログラミングスキルがなくても取り組めます。

- データの加工が容易: 収集したデータをExcel上で加工・分析することが簡単に行えます。

Excelでスクレイピングする際の注意点は何ですか?

Excelでスクレイピングする際には、以下の点に注意してください。

- Webサイトの規約: スクレイピングを行う前に、対象のWebサイトの規約を確認し、データ収集が許可されていることを確認してください。

- リクエスト間隔: タイトなループでリクエストを送信すると、Webサイトのサーバーに負担がかかったり、アカウントがBANされるリスクがあります。適切な間隔を設けてリクエストを送信してください。

- データの整形: 収集したデータは、Webページの構造に応じて整形が必要な場合があります。データをExcelで活用するためには、適切な整形処理を施すことが重要です。